IT时报记者 毛宇

近日,国家超算互联网平台宣布上线MiniMax国产AI大模型,其中基础语言大模型MiniMax-Text-01和视觉多模态大模型MiniMax-VL-01现已入驻超算互联网AI开源社区。与此同时,超算互联网ChatBot对话服务也同步接入,用户可体验智能、自然的AI对话。

MiniMax专注于多模态通用大模型研发应用,其技术覆盖文本、语音、图像及视频领域。自研模型架构在长文本处理、多模态融合等方面表现突出。此次入驻的两款模型通过创新算法优化,进一步提升了长文本处理效率。

国家超算互联网平台作为国家级算力服务平台,今年2月启动“AI生态伙伴加速计划”,通过技术、资源及市场协同,促进创新链与产业链对接。MiniMax入驻国家超算平台后,双方计划推动国产大模型加速发展,助力更多应用开发者开展有价值、突破性的研究,为国内AI产业发展注入新动力。

国产自研新架构解决大模型“卡脖子”问题

今年年初,MiniMax发布并开源新一代系列模型MiniMax-01,首次将线性注意力机制扩展到商用模型的级别,并使其综合能力达到全球领先梯队。模型上下文长度直接达到了顶尖模型的20-32倍水平,推理时的上下文窗口能达到400万token,模型效果立刻引起关注。

放眼国内外大模型,“大脑”虽大,但“记忆力”还不够用。以处理复杂文本为例,若要求AI秒速理解一本1000页的法律合同、一本科幻小说或是一个几十万行的源代码项目,并准确提炼摘要、发现潜在风险、提供结构化建议,多数模型往往力不从心,甚至连完整读取文本都难以实现,在音视频等多模态信息处理方面更是捉襟见肘。

但MiniMax-01上下文窗口能达到400万token,约等于700万字的上下文窗口,帮助其秒速读完四大名著和哈利波特全集,为多模态信息处理难题提供了创新性解决方案。

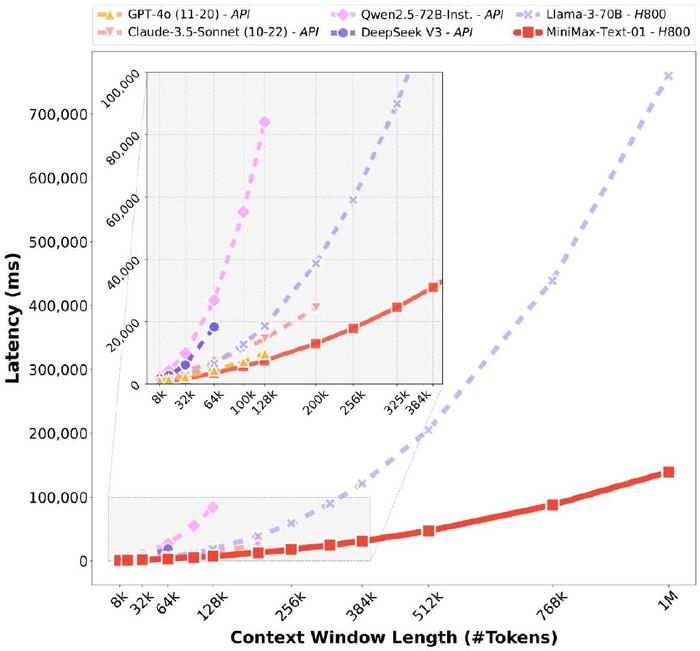

全球首个大规模应用线性注意力机制开源模型

在架构上,MiniMax的Text-01几乎重构了训练和推理系统,模型的参数量高达4560亿,每次激活459亿。在注意力机制层面,MiniMax-01做了大胆的创新,在业内首次实现了新的线性注意力机制,“它的80层注意力层里,每一层softmax attention层前放置了7层线性注意力lightning attention层。受益于架构创新,模型在处理长输入的时候在保持快速处理效果的同时做到了低延迟。”MiniMax工作人员解释道。

基于MiniMax-Text-01,MiniMax还开发了一个多模态版本:MiniMax-VL-01。在文本模型的基础上整合一个图像编码器和一个图像适配器,将图像变成LLM能够理解的token形式。VL-0不仅继承了文本处理的高效性,还具备强大的视觉理解能力,在多种视觉语言任务基准测试中展现出超高性能。

开放协作 助推创新链产业链相融

随着Agent进入应用场景,无论是单个Agent工作时产生的记忆,还是多个Agent协作所产生的context,都会对模型的长上下文窗口提出更多需求。因此,长上下文能力与多模态处理能力的提升,是AI Agent为各行业带来更为丰富、高效、智能的解决方案的必要条件。

作为国家级算力服务平台,国家超算互联网由科技部指导发起,于2024年4月正式上线,平台集算力、应用、数据、生态、社区等于一体,通过链接我国算力产业上下游及供需双方资源,让创新链和产业链无缝对接。此次与MiniMax联手,未来可推动国产大模型技术加速发展。MiniMax表示,“这有可能启发更多长上下文的研究和应用,更快促进Agent时代的到来,开源也能促使我们努力做更多创新,更高质量地开展后续的模型研发工作。”