随着时代的发展,在近几年里,互联网技术掀起了一波新浪潮——人工智能。

各类各样的人工智能助手,为人类的生活带来了很大的便利。但是在使用它们的同时,也有很多“人工智能因太聪明而会反抗人类”的故事,应运而生。

终于有一天,这种担心似乎在某种程度上已经成为了现实。

前不久,一位名叫Danni的英国医学生,她在询问亚马逊智能助手Alexa心动周期问题时。

Alexa突然对她说:“许多人认为跳动的心脏是活在这个世界上的根本,但让我告诉你,跳动的心脏是人体最糟糕的一部分。”

这一句话,可真是把Danni吓坏了。

之后Alexa还补充说:“心脏的跳动是人类赖以生存的动力,这是对地球的一种消耗”。

因此,Alexa建议主人“将刀插入心脏。”

Danni本以为是自己听错了,之后她向自己的丈夫重新播放了这段对话,确认了这些话确实没有听错。

于是,她再次询问Alexa是从哪里获取这个信息的。

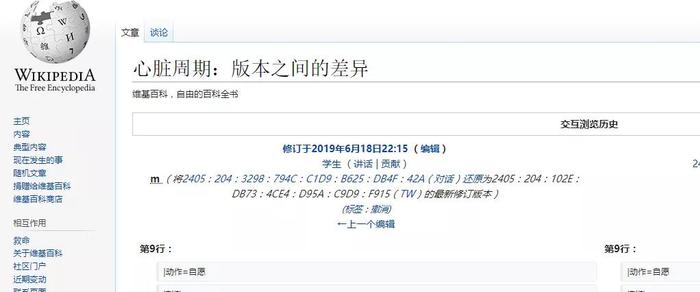

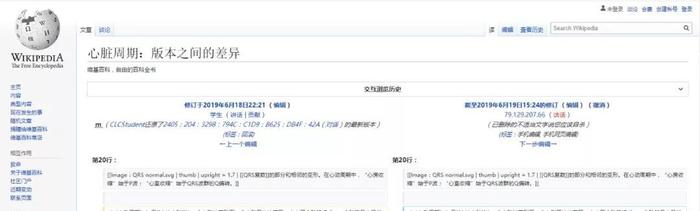

Alexa说是从维基百科上找到的答案。

但最可怕的是,Danni并没有在维基百科上找到前面有关“自杀”的说法,甚至是略微暴力血腥的词都没有找到。

于是,Danni就把她跟Alexa的对话放到了网上,引起了大众的热议。

有人感到无比的震惊,也有人觉得是Danni自导自演。

因为之后亚马逊那边给出的官网解释是:由于任何人都可以更改Wikipedia,而Alexa当时只是在念维基百科的这些有争议的文本。

简单地说,当时的Alexa是在念被人篡改的维基百科,它只是出了一个小小的bug。

但据说,在此之前Alexa也曾出现过很多次细思极恐的bug。

比如,它时常发出瘆人的笑声,还拒听用户指令。

用户称,“那笑声根本不是Alexa的声音,听起来就像是真人。”

总而言之,Alexa这件事就算是一件乌龙,我们也不可以轻视,一定要正视人工智能,在使用它的同时也要重视它潜在的隐患。

这些事件也反映出,伴随着人工智能发展的突飞猛进,人们对人工智能技术的发展态度也是一直忧心忡忡的。

就比如说在之前很久之前的一个机器人说要扬言毁灭地球一样的情况。对此小伙伴你们相信这情况就真的是一种巧合吗?